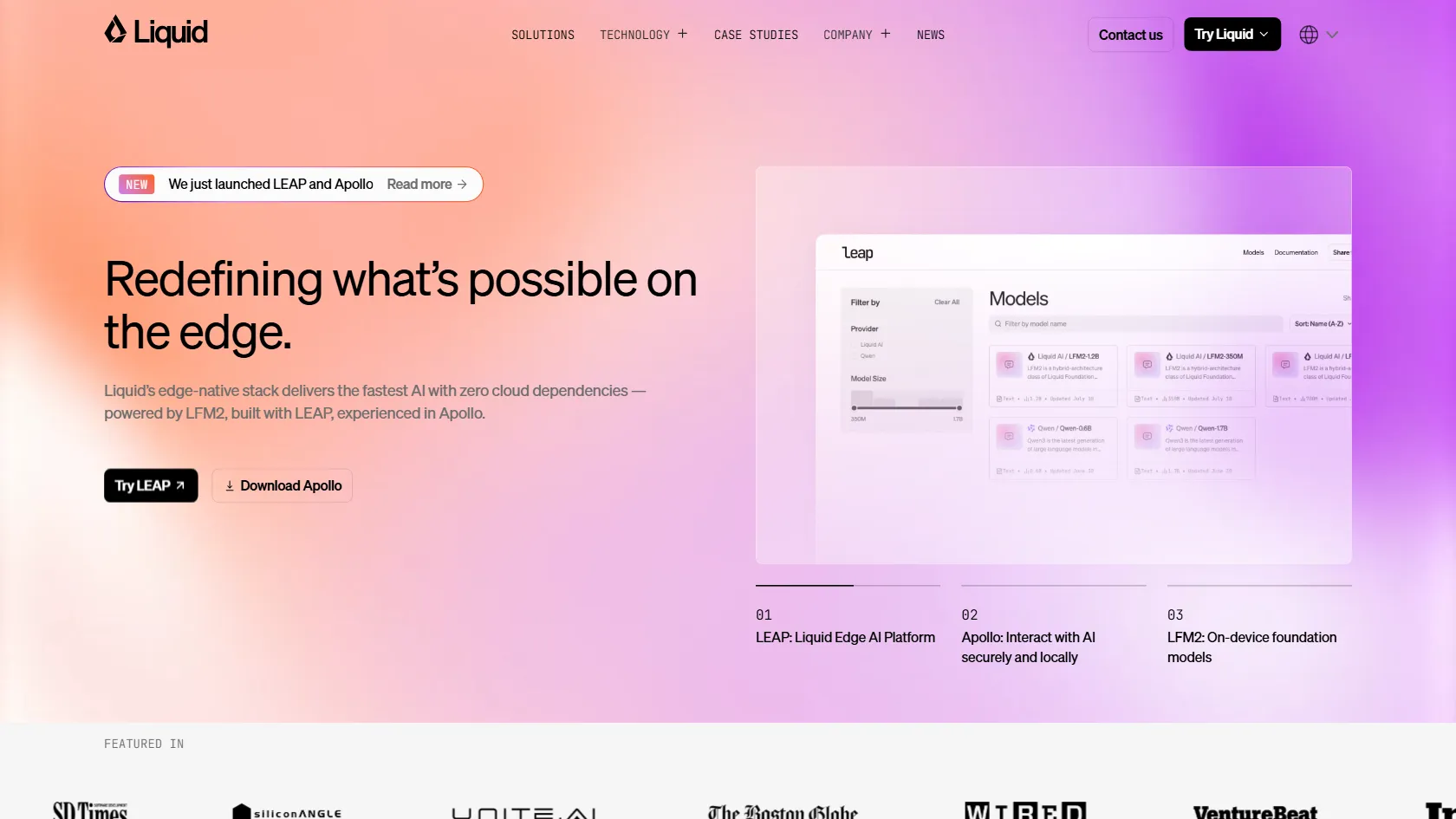

Liquid AI专注于开发高效的通用AI模型,称为Liquid Foundation Models (LFMs)。这些模型在各种规模下均实现最先进的性能,同时减少内存使用并提升推理效率。受生物神经系统的启发,LFMs采用液态神经网络处理复杂、序列化和多模态数据,具备卓越的推理能力。该平台包括LEAP用于边缘AI部署和Apollo用于本地AI交互,为企业与开发者提供可定制解决方案,以优化AI工作流程,无需依赖云端。通过先进的优化技术,LFMs在边缘计算和云计算环境中均表现出色,支持从文本生成到图像分析的广泛应用,帮助用户降低计算成本、提高响应速度,并增强数据隐私保护。

如何使用 Liquid AI? 开发者和企业可使用Liquid AI在边缘设备或云端部署AI模型。用户通过API访问模型,将其集成到应用中,用于自然语言处理、计算机视觉或多模态数据分析等任务。它通过提供高效推理解决高计算成本和延迟问题,非常适合物联网、移动设备或企业系统中的实时应用。只需使用提供的工具或API,即可根据特定硬件和任务定制模型。

Liquid AI 的核心功能

Liquid Foundation Models (LFMs) 提供最先进的性能,内存占用减少,可在从边缘到云的各种设备上高效部署。 LEAP (Liquid Edge AI Platform) 提供全栈工具包,用于自定义AI架构、优化数据、策略和硬件,实现无缝高性能部署。 Apollo 允许安全本地与AI模型交互,用户可在设备上直接运行AI,无需互联网连接,提升隐私和速度。 通过超越传统变压器的优化推理技术,最大化计算效率,提供更快的AI和更低的功耗。 可定制模型使工程师能够根据特定业务需求调整LFMs,包括架构调整和多模态数据处理。 受生物神经系统启发,网络实时适应和学习,提供比静态AI模型更高的灵活性和效率。 支持小语言模型和视觉语言模型,确保从文本生成到图像分析等广泛应用的多样性。 Liquid AI 的使用场景

开发者构建移动应用时,可使用Apollo集成设备端AI,用于语言翻译或图像识别等任务,减少延迟并确保数据隐私,无需依赖云服务,从而提升用户体验和应用性能。例如,在旅行应用中,实时翻译功能可在离线状态下工作,避免网络延迟问题,提供更流畅的交互。 物联网公司在部署边缘设备时,利用LEAP运行高效AI模型,用于智能家居或工业环境中的实时数据处理,降低云成本并在低连接环境中增强可靠性。具体案例中,智能工厂使用LEAP处理传感器数据,实现预测性维护,减少停机时间并提高生产效率。 拥有大规模数据工作流程的企业通过API使用LFMs处理复杂序列数据分析,如金融预测或客户情感分析,优化计算资源并加速决策过程。例如,金融机构使用LFMs分析交易数据,快速识别市场趋势,支持投资决策,减少计算开销。 AI和机器学习研究人员使用Liquid AI的模型进行多模态数据实验,受益于灵活架构测试新算法,并在模型开发中实现更快迭代。案例包括研究团队使用LFMs处理图像和文本数据,开发新型推荐系统,提升实验效率。 专注于AI驱动产品的初创公司利用LFMs的可定制功能,快速将模型适应利基市场,如医疗诊断或自主系统,缩短上市时间并降低运营成本。例如,医疗科技公司使用LFMs定制图像识别模型,用于早期疾病检测,提高诊断准确性。 教育机构将Liquid AI集成到课程中,用于教授AI概念,允许学生在个人设备上实验高效模型,促进实践学习,无需昂贵基础设施。案例中,大学课程使用Apollo工具,让学生构建本地AI项目,增强动手能力。 Liquid AI 的常见问题 什么是Liquid Foundation Models?

最受影响的职业 软件开发人员

数据科学家

AI研究员

物联网工程师

企业架构师

初创公司创始人

教育工作者

产品经理

DevOps工程师

研究科学家

Liquid AI 的标签 Liquid AI 的替代品